简介

论文来源: Multi-Scale Feature Interactive Fusion Network for RGBT Tracking

现有的模型总是忽略了特征之间丰富的上下文信息. 在本文中, 作者将使用多尺度特征提取的方法, 使用通道感知模块计算分支可靠性, 并用 Transformer 进行特征交互. 此外, 还有一个全局特征融合模块, 用以平衡不同场景下的模态贡献, 自适应调整空间和通道维度上的全局特征.

方法

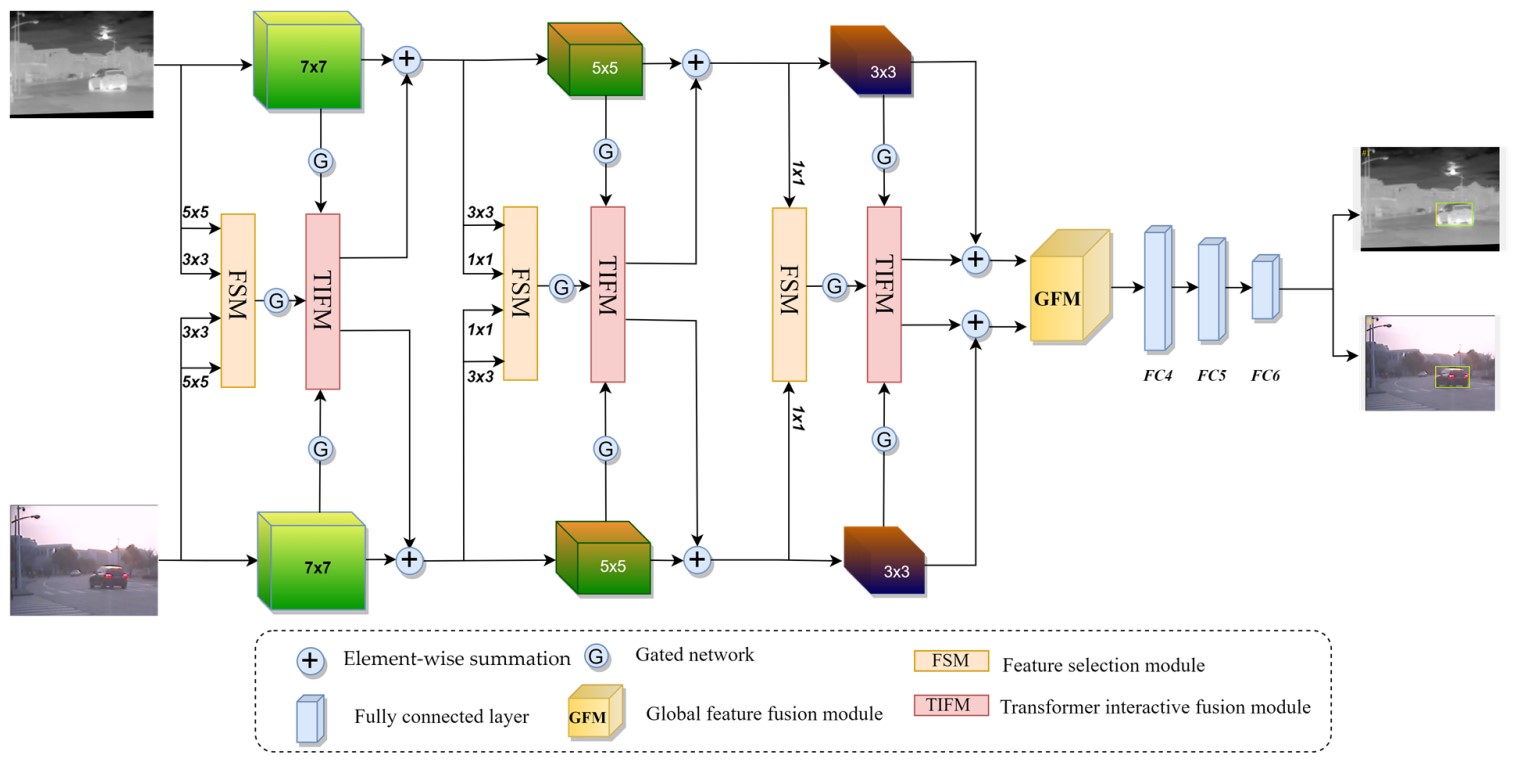

上图展示了该模型的框架, 可以看出, 作者使用了两个对称的并行结构来挖掘两种模态潜在信息, 使用了卷积核大小为 的 VGG-M 的前 3 层. 其中前两层的卷积之后有 ReLU 和局部响应归一化和最大池化, 第三层卷积之后仅有 ReLU.

不同的卷积核有不同的感受野, 能够适应不同尺寸的目标, 因此作者为前两层额外增加了多个小卷积核, 对于不同大小的特征图, 使用最大池化将分辨率固定为确切值. 特征选择模块(FSM)能够自适应激活来自不同分支的特征, 以便进行聚合. 此外, 作者还设计了门控网络来阻止噪声传播. 接下来将详细介绍模块功能.

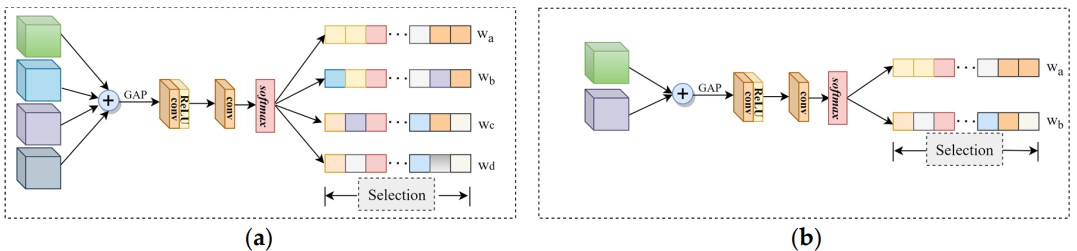

特征选择模块(FSM): 下图展示了 FSM 的结构, 左侧为一二两层, 右侧为第三层. 该模块能够使用少量的参数获得更多的线索. 首先, 它将输入的特征直接相加, 再使用全局平均池化获得信道向量. 经过两个 卷积和 后, 得到通道权重, 使用该权重对原始特征加权, 让模型专注于重要的信息.

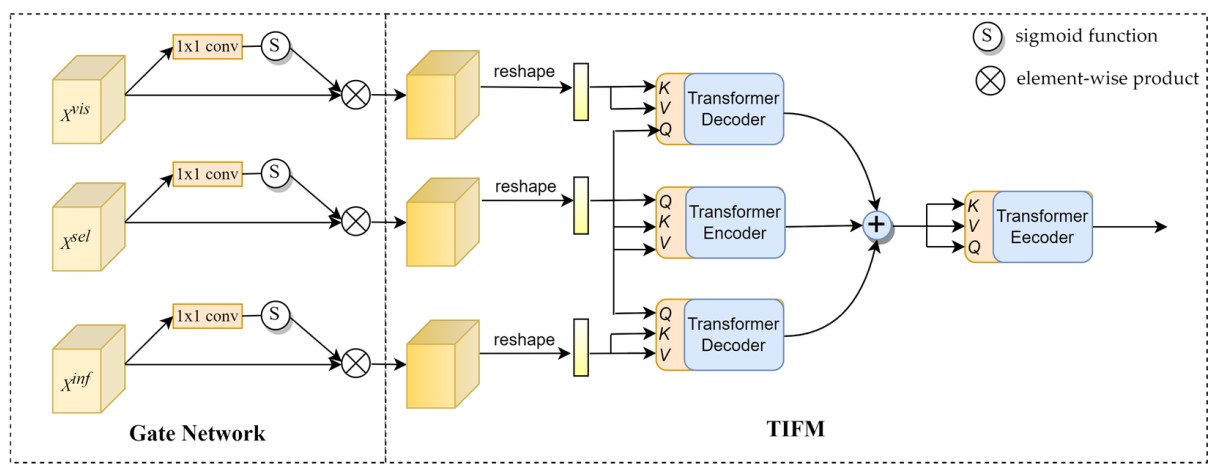

Transformer 互动融合模块(TIFM): 下图展示了 GN 与 TIFM 的结构. 其输入包括两个模态特征与聚合特征, 为了减少冗余, 门控网络(Gate Network)通过卷积与激活函数来自适应调整输入.

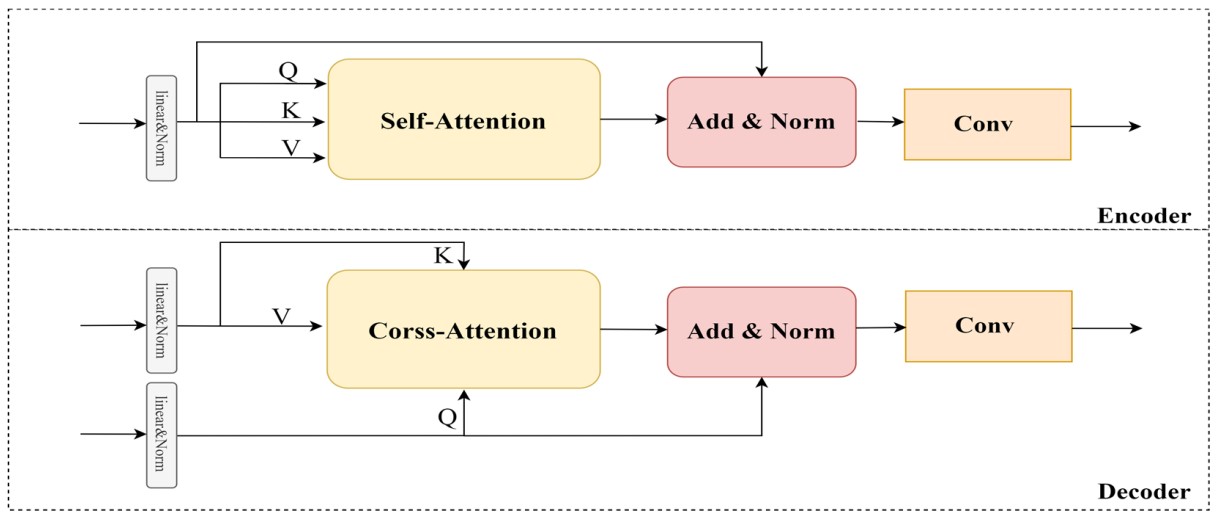

下图展示了 TIFM 的详细结构, 作者去掉了原 Transformer 的位置编码与前馈网络, 以降低模型复杂度. 每个输入通过线性变换的方式产生矩阵 , 与一般的注意力机制的不同点在于, 作者将 作为残差添加到 的输出中. 在编码器中, 自注意力机制帮助模型学习特征之间的远程依赖性, 解码器使用交叉注意力, 其 矩阵来自另一个序列, 使得解码器能够关注编码器的输出. 其中融合特征得到的 被用于两个模态的查询矩阵.

通过该结构, 使得编码器能够自我增强, 解码器能够聚合模态特征与融合特征. 再使用逐元素求和来结合多个增强特征, 再连接一个编码器, 最终输出即 TIFM 输出.

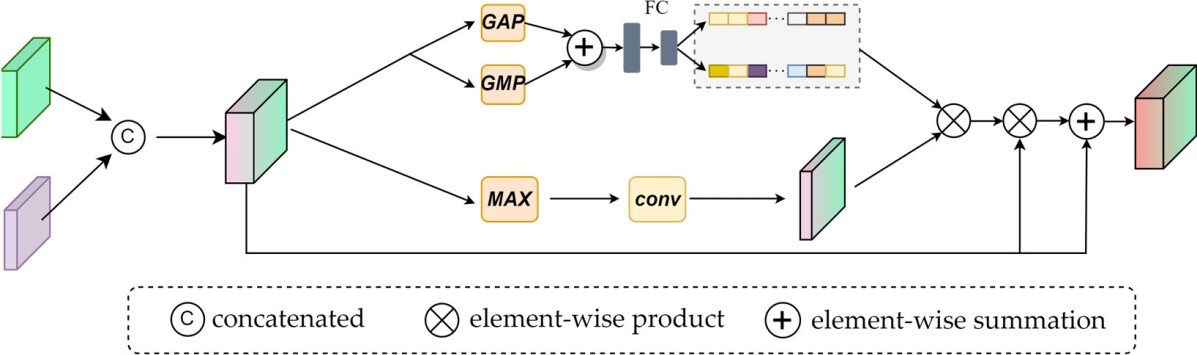

全局特征融合模块(GFM): 下图展示了 GFM 的结构. 该模块的目的是权衡两种模态的贡献, 先将两个模态的特征相连. 上半分支使用平均池化和最大池化, 并将结果逐元素相加, 接着使用两个全连接层和一个 对通道向量进行非线性变换, 得到通道权重. 下半的 MAX 操作是指求出每个空间位置的对应通道的最大值, 随后用 卷积得到空间权重, 同时突出显示候选位置并抑制干扰.

若用 表示初始特征, 表示 , 表示空间权重与通道权重, 表示逐元素相乘, 则最终输出可以表示为: